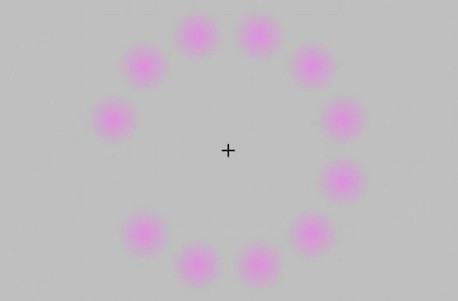

Mire fijamente la cruz en el centro de la imagen y antes de que usted se de cuenta, tendrá un rectángulo completamente gris. Los círculos rosados se encuentran en la periferia de nuestro campo visual y, a pesar de estar físicamente presente, las manchas de color rosa no estimulan suficientemente nuestras neuronas para mantener la percepción visual. El fenómeno se conoce como «desvanecimiento de Troxler», descubierto por el médico suizo Ignaz Paul Vital Troxler en el año 1804. Pero nosotros, los seres humanos, no somos los únicos que sufren de ilusiones ópticas.

Sabemos que las computadoras pueden mirar al mundo y reconocer lo que ven, a través de un software de reconocimiento de imágenes. Pueden escoger objetos y personas, e incluso distinguir caras y emociones individuales. ¿Pero qué es lo que realmente perciben?

Esa es la pregunta principal de un nuevo estudio en relación a la inteligencia artificial y reconocimiento de patrones. Los investigadores de este estudio descubrieron que, quizás no tan sorprendentemente, los ordenadores ven un mundo muy diferente al nuestro.

Jeff Clune de la Universidad de Wyoming y sus colegas querían saber si podían conectar un determinado tipo de algoritmo de reconocimiento de imágenes, llamada “red neural profunda” (DNN), a un segundo algoritmo diseñado para evolucionar diferentes imágenes.

Previamente, tales algoritmos genéticos, vinculados con el juicio humano, han creado imágenes de manzanas y caras. Dado esto, Clune se preguntó si la red neural profunda podría generar imágenes creativas sin la ayuda de los seres humanos, solo trabajando junto con el algoritmo genético.

Posteriormente, el equipo emparejó ese proceso con un segundo algoritmo genético, lo cual evoluciona nuevas imágenes basadas en la “información” de las antiguas. A modo de una técnica, a veces llamada arte evolutivo, el algoritmo genético se transforma en la imagen original con la ayuda de la orientación humana. En este caso, los investigadores reemplazaron la selección humana de las imágenes con entrada de DNN y consiguieron algunos resultados extraños.

“Esperábamos que nos diera una gran cantidad de imágenes reconocibles de muy alta calidad”, señaló el investigador Jeff Clune a la revista New Scientist. «En vez de esto nos arrojó imágenes bastante extrañas: un guepardo que no se parece en nada a un guepardo».

Imágenes de autos, pingüinos, pavos reales y una pelota baseball creadas por la DNN

De hecho, el proceso resultó en imágenes que se ven como arte abstracto o ruido blanco visual, pero la DNN identificó con un 99 % de certeza que eran objetos específicos – una pelota de béisbol, por ejemplo, o una guitarra eléctrica. Son ilusiones ópticas para ordenadores, en esencia algo que podría plantear problemas para aplicaciones como en los sistemas de seguridad de reconocimiento facial.

La diferencia es que los seres humanos identifican un objeto mediante la visualización del cuadro completo, mientras que las DNN seleccionan mediante la búsqueda de las partes de un objeto que más lo distinguen de otros.

En cierto modo, no es sorprendente que los algoritmos de reconocimiento de imágenes puedan ser engañados, sin embargo, las ilusiones ópticas atrapan a los humanos todo el tiempo.

«Todas las ilusiones ópticas están hackeando el sistema visual de los seres humanos, en el mismo sentido en que nuestro papel está hackeando el sistema visual de la DNN para engañarle a ver algo que no está ahí», dijo Clune.

El estudio de estas ilusiones y las diferencias entre los algoritmos y los seres humanos podría enseñarnos más sobre nosotros mismos, expresó Jürgen Schmidhuber del Instituto Dalle Molle de Investigación en Inteligencia Artificial en Manno, Suiza.

Clune quiere encontrar la manera de ayudar a la DNN a ignorar las ilusiones. Si ellas pueden ser engañadas por la estática, un atacante puede ser capaz de eludir los sistemas de seguridad de reconocimiento facial.

Fuente: NewScientist / Discovery