Científicos de EEUU y Canadá desarrollaron un algoritmo que replica la capacidad humana de aprendizaje y que permite a los computadores reconocer y extraer sencillos conceptos visuales como lo hacen las personas. Los resultados del estudio se publican en la revista Science.

Un algoritmo se define como un conjunto ordenado y finito de operaciones, que permite encontrar la solución de un problema.

Según Brenden Lake, investifador de Moore-Sloan Data Science en la Universidad de Nueva York, el trabajo “acorta el proceso computacional de aprendizaje de nuevos conceptos y amplía la aplicación de las máquinas a tareas más creativas”.

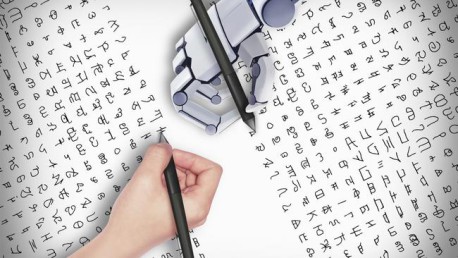

Cuando los seres humanos afrontan un nuevo concepto –por ejemplo, descifrar cómo funciona un electrodoméstico, aprender un nuevo paso de baile o una letra de un alfabeto diferente– necesitan solo unos pocos ejemplos para entender su funcionamiento y reconocer nuevos casos. En cambio, los computadores necesitan cientos o hasta miles de instrucciones para operar de una manera similar.

Para aproximarse a la manera humana de aprender, los investigadores crearon un Programa Bayesiano de Aprendizaje (BLP, por su sigla en inglés), en el que los conceptos se representan como programas informáticos sencillos.

Por ejemplo, la letra ‘A’ está representada por un código que emite ejemplos de esa letra cuando se ejecuta. Sin embargo, no se requiere un programador durante el proceso de aprendizaje, ya que el algoritmo se programa a sí mismo construyendo un código para producir la letra que ve.

También, a diferencia de los programas computacionales estándar, que producen el mismo resultado cada vez que se ejecutan, estos programas probabilísticos generan diferentes salidas en cada ejecución. Esto les permite captar cómo varían las manifestaciones de un mismo concepto, por ejemplo, las diferentes maneras en que dos personas dibujan la letra ‘A’.

Mientras que los algoritmos de reconocimiento de patrones estándar representan conceptos como configuraciones de píxeles o colecciones de características, el enfoque BPL aprende ‘modelos generativos’ de procesos reales, lo que permite utilizar los datos de manera más eficiente.

El modelo también ‘aprende a aprender’. Por ejemplo, utiliza el conocimiento del alfabeto latino para aprender las letras del alfabeto griego. Los autores aplicaron su modelo a más de 1.600 tipos de caracteres escritos a mano en 50 de los sistemas de escritura que hay en el mundo y también incluyeron letras de alfabetos inventados, como los de la serie de televisión Futurama.

“Antes de entrar en la enseñanza preescolar, los niños ya saben reconocer nuevos conceptos a partir de un solo ejemplo y pueden imaginar nuevos ejemplos que nunca han visto”, explica Joshua Tenenbaum, profesor de Brains, Minds and Machines del MIT y coautor del estudio.

Según Tenenbaum, “todavía estamos lejos de construir máquinas tan inteligentes como un niño, pero esta es la primera vez que podemos hacer que un computador sea capaz de aprender y usar un gran número de conceptos del mundo real, incluidos conceptos visuales simples como caracteres escritos a mano”.

Via NCYT