En los últimos días, las redes sociales se han visto colmadas de impresionantes retratos digitales hechos por inteligencia artificial basados en las fotos que envían los usuarios. Sin embargo, las mujeres han comenzado a notar que ‘Lensa’, como se llama la aplicación, hace que su piel luzca más clara o las representa sexualizadas.

«¿Los avatares de todos eran igual de sexuales? ¿Por qué la mayoría de los míos están desnudos?, cuestionó la actriz Megan Fox a través de su cuenta de Instagram, de la compañía estadounidense Meta, prohibida en Rusia por actividades extremistas, en donde compartió varios de los avatares que la app generó para ella.

Melissa Heikkilä, reportera sénior de inteligencia artificial en el MIT Review, informó que, mientras la aplicación creó avatares realistas de sus colegas hombres, como astronautas y guerreros feroces, ella obtuvo toneladas de desnudos.

«De los 100 avatares que generé, 16 estaban en topless y, en otros 14, me habían puesto ropa extremadamente diminuta y poses abiertamente sexualizadas», escribió la especialista.

Otro problema que las mujeres han detectado al utilizar la aplicación es existe un sesgo racista. Por ejemplo, Heikkilä compartió que tiene ascendencia asiática, «y eso parece ser lo único que el modelo de IA captó de mis fotos».

«Obtuve imágenes de mujeres asiáticas genéricas claramente modeladas en personajes de anime o videojuegos. O muy probablemente porno, teniendo en cuenta la gran cantidad de mis avatares que estaban desnudos o mostraban mucha piel», detalló la periodista.

Sin embargo, Heikkilä observó que su colega de piel blanca obtuvo significativamente menos imágenes sexualizadas, con solo un par de desnudos y toques de escote. Mientras que otra colega de ascendencia china obtuvo resultados similares a los suyos, con montones de avatares pornográficos.

Los filtros antisesgos

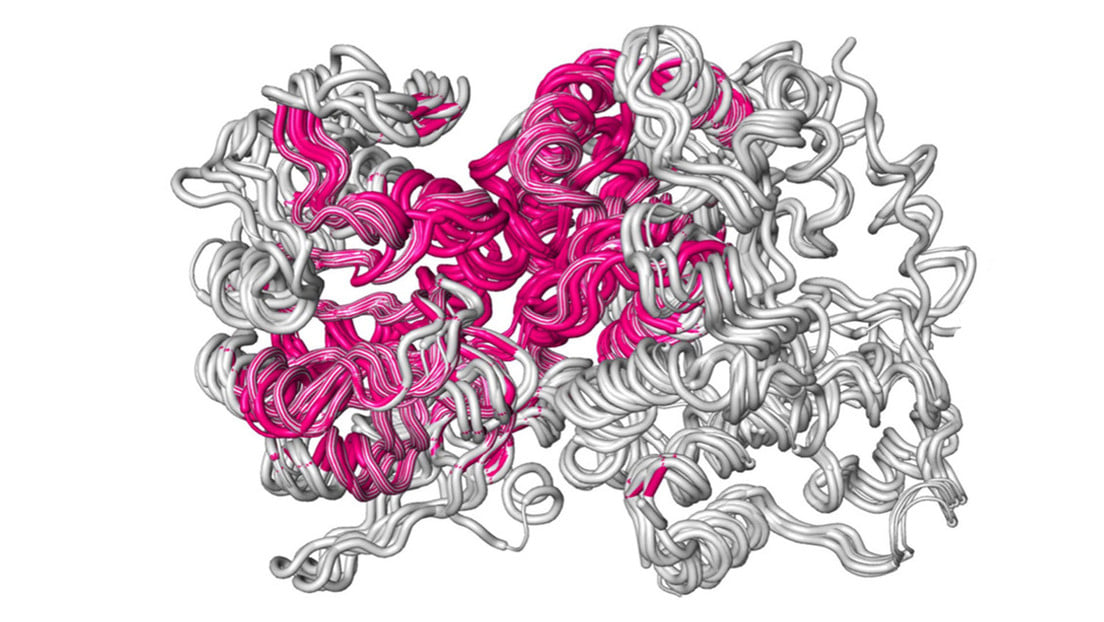

De acuerdo con Aylin Caliskan, profesora asistente en la Universidad de Washington que estudia los sesgos y la representación en los sistemas de inteligencia artificial (IA), a quien Heikkilä cita en su artículo, Lensa genera sus avatares utilizando Stable Diffusion, un modelo de IA de código abierto que genera imágenes basadas en indicaciones de texto.

Dicho modelo se construye utilizando LAION-5B, un conjunto masivo de datos de código abierto que se ha compilado extrayendo imágenes de internet. Sin embargo, internet está repleto de imágenes de mujeres desnudas o apenas vestidas, así como de imágenes que reflejan estereotipos sexistas y racistas.

«Esto conduce a modelos de IA que sexualizan a las mujeres independientemente de si quieren ser representadas de esa manera (…) especialmente mujeres con identidades que históricamente han estado en desventaja», explica Caliskan.

Agrega que los datos de entrenamiento de IA están llenos de estereotipos racistas, pornografía e imágenes explícitas de violaciones, tal como lo descubrieron investigadores tras analizar un conjunto de datos similar al que se usó para Stable Diffusion. Sin embargo, dichos hallazgos solo fueron posibles gracias a que el conjunto de datos de LAION es de código abierto, algo que no sucede con la mayoría de las otras IA de creación de imágenes populares, como es el caso de DALL-E, una aplicación de IA capaz de crear imágenes a partir de asociación de conceptos visuales y textuales.

A pesar de que la nueva versión de Stable Diffusion permite filtrar por imágenes repetitivas, lo que reduce que siempre se introduzca el mismo concepto, como el de mujeres asiáticas, Lensa no aplica el filtro todavía.

Por otro lado, el problema no se reduce a los datos de entrenamiento que utiliza esta tecnología, pues las empresas que desarrollan estos modelos y aplicaciones toman decisiones activas sobre cómo usan los datos, explica Ryan Steed, estudiante de doctorado en la Universidad Carnegir Mellon citado por Melissa Heikkilä.

«Alguien tiene que elegir los datos de entrenamiento, decidir construir el modelo, decidir tomar ciertos pasos para mitigar esos sesgos o no», cuenta Steed.

Sin embargo, los desarrolladores de Lensa han elegido que los avatares masculinos aparezcan en trajes espaciales, mientras que los avatares femeninos obtengan tangas cósmicas y alas de hadas.

«Las mujeres se asocian con contenido sexual, mientras que los hombres se asocian con contenido profesional relacionado con la carrera en cualquier dominio importante, como medicina, ciencia, negocios, etc.», apunta Caliskan.

Fuente Sputnik

Te puede interesar